2026년 업무용 메신저 추천과 슬랙 잔디 팀즈 완벽 비교 가이드

Tech in Depth Hub는 최신 IT 기술, 소프트웨어 개발, 프로그래밍, 게임 개발과 게임 산업 트렌드를 깊이 있게 다루는 기술·게임·투자 블로그입니다. 웹 개발, 백엔드, 프론트엔드, 데이터베이스, 클라우드, AI, 사이버 보안부터 콘솔·PC·모바일 게임 뉴스와 투자 분석까지 폭넓게 다룹니다. 실무에서 활용 가능한 코드 예제, 개발 노하우, 게임 제작 팁을 제공하며, 개발자·게이머·IT 종사자 모두에게 가치 있는 정보를 전합니다. 빠르게 변화하는 기술과 게임 환경 속에서 필요한 지식과 인사이트를 제공합니다.

2026년 AI 서비스의 경쟁력은 단순한 정확도를 넘어 속도와 비용 효율성에 달려 있습니다. PyTorch 모델을 ONNX로 변환하고 TensorRT로 최적화하는 과정은 하드웨어 성능을 100% 이끌어내기 위한 필수 단계입니다. 이 가이드는 실무에서 즉시 적용 가능한 변환 코드, 오류 해결법, 그리고 극한의 성능을 위한 최적화 로드맵을 핵심만 요약해 제공합니다.

2026년 현재, 우리는 거대언어모델(LLM)과 복합적인 멀티모달 모델이 데이터센터를 넘어 스마트폰, 로봇, 엣지 디바이스에서 실시간으로 구동되는 세상에 살고 있습니다. 이제 AI 모델의 경쟁력은 단순한 '정확도'를 넘어, 얼마나 빠르고 효율적으로 서비스할 수 있느냐인 '속도와 비용'에서 판가름 납니다.

많은 개발자가 연구 단계에서는 PyTorch를 선호합니다. 직관적이고 코딩이 쉽기 때문입니다. 하지만 PyTorch의 네이티브 방식(Eager Mode) 그대로 실제 서비스(Production)에 배포하면 심각한 문제에 직면합니다. 바로 높은 지연 시간(Latency)과 과도한 메모리 사용량입니다. NVIDIA의 최신 Blackwell GPU나 엣지용 NPU의 성능을 100% 끌어내기 위해서는 모델을 하드웨어에 맞게 번역하고 압축하는 과정이 필수적입니다.

여기서 PyTorch ONNX 변환 및 최적화가 등장합니다. ONNX(Open Neural Network Exchange)는 단순한 파일 확장자가 아닙니다. 여러분의 모델이 특정 프레임워크를 떠나 다양한 하드웨어 환경으로 입국할 수 있게 해주는 '공통 여권'과 같습니다. 이 가이드는 여러분이 애써 만든 모델이 실전에서 최고의 성능을 내도록, 변환부터 오류 해결, 그리고 TensorRT를 통한 극한의 최적화까지 모든 노하우를 제공합니다.

성공적인 배포의 첫 단추는 깔끔한 변환입니다. PyTorch to ONNX 변환 가이드의 핵심은 모델을 단순한 정적 그래프로 만드는 것이 아니라, 가변적인 실제 입력 상황에 대응할 수 있도록 만드는 데 있습니다.

model.eval()

변환 코드를 작성하기 전, 반드시 모델을 평가

모드(model.eval())로 전환해야 합니다. 이를 간과하면 학습 시

사용되는 드롭아웃(Dropout)이나 배치 정규화(Batch Normalization) 레이어가

추론 과정에서도 동작하여, 엉뚱한 결과값을 내놓게 됩니다.

아래는 2026년 실무 환경에서 가장 권장되는 표준 변환 코드입니다.

import torch

import torch.onnx

# 1. 모델 준비 및 평가 모드 전환 (필수!)

model = MyModel().eval()

# 2. 더미 입력 데이터 생성 (실제 모델 입력과 동일한 형태)

# 실제 데이터가 흐르는 모든 경로를 활성화하기 위해 의미 있는 값을 넣는 것이 좋습니다.

dummy_input = torch.randn(1, 3, 224, 224, requires_grad=True)

# 3. ONNX 추출

torch.onnx.export(

model, # 실행할 모델

dummy_input, # 모델 실행을 위한 더미 입력

"model_optimized.onnx", # 저장될 파일 경로

export_params=True, # 모델 가중치 저장 여부

opset_version=17, # 2026년 기준 호환성/성능 최적 버전 (타겟 런타임 확인 필요)

do_constant_folding=True, # 상수 폴딩 최적화 (상수 연산을 미리 계산하여 그래프 단순화)

input_names=['input'], # 입력 노드 이름 정의

output_names=['output'], # 출력 노드 이름 정의

dynamic_axes={ # 가변적인 차원 설정 (배치 사이즈 등)

'input': {0: 'batch_size'},

'output': {0: 'batch_size'}

}

)

opset_version: 무조건 최신 버전이 좋은 것은 아닙니다. 배포하려는 환경(예: 특정 모바일

NPU)이 지원하는 ONNX Operator Set 버전을 확인해야 합니다. 2026년

기준으로는 보통 Opset 17 이상이 안정적입니다.

dynamic_axes: 실제 서비스에서는 사용자가 1명일 수도, 100명일 수도 있습니다. 입력

데이터의 배치 크기(Batch Size)나 시퀀스 길이(Sequence Length)가 변할 수

있다면, 반드시 이 옵션을 설정해 고정된 크기로 박제되는 것을 막아야 합니다.

onnxscript나 PyTorch 2.x의 torch.export를

활용하면 훨씬 안정적으로 변환할 수 있습니다.

더 자세한 정보가 필요하다면 공식 문서를 확인하세요. PyTorch 공식 ONNX 문서 → ONNX Script 깃허브 →

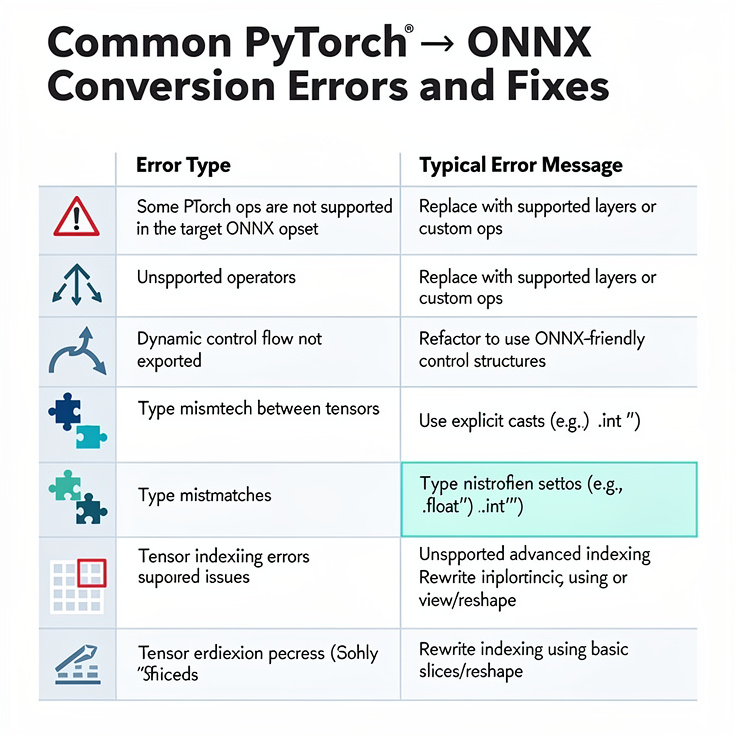

변환 버튼을 눌렀을 때 한 번에 성공하는 경우는 드뭅니다. 파이토치 모델 변환 오류 해결 능력은 엔지니어의 숙련도를 보여주는 척도입니다. 자주 발생하는 문제와 해결책을 정리했습니다.

| 오류 유형 | 증상 및 에러 메시지 | 해결 방법 (Action Item) |

|---|---|---|

| 미지원 연산자 |

Exporting the operator X to ONNX... not supported

|

1. opset_version 높이기2. 커스텀 변환 로직 등록 3. 기본 연산 조합으로 리팩토링 |

| 제어 흐름 이슈 |

if문이나 for문 소실, 고정됨

|

1. torch.jit.script 사용2. 텐서 연산(Masking)으로 변경 |

| 타입/장치 불일치 |

RuntimeError: Input type (float) and weight type (half)

|

1. 장치 및 타입 통일 확인 2. 하드코딩된 .cuda() 제거

|

| 텐서 인덱싱 오류 | 복잡한 슬라이싱 실패 |

1. 단순 슬라이싱으로 변경 2. torch.gather 등 명시적

함수 사용

|

변환 직후의 ONNX 그래프는 불필요한 연산이나 복잡한 노드들이 섞여 있어

지저분합니다. onnx-simplifier는 이러한 그래프를 정리해주는

'청소부' 역할을 합니다.

pip install onnx-simplifier 후

터미널에서 onnxsim input.onnx output.onnx 입력.

관련 도구는 여기에서 확인하세요. ONNX Simplifier → PyTorch JIT 문서 →

고생해서 변환한 모델, 얼마나 빨라졌을까요? ONNX Runtime 추론 속도 비교를 통해 그 가치를 증명할 차례입니다. ONNX Runtime(ORT)은 다양한 하드웨어 가속기(Execution Provider)를 플러그인처럼 교체하며 사용할 수 있는 고성능 엔진입니다.

실제 벤치마크 결과, 순수 PyTorch 대비 ONNX Runtime은 약 20%에서 최대 50% 이상의 성능 향상을 보입니다.

| 실행 환경 (Runtime) | Latency (지연 시간) | Throughput (처리량) | 특징 |

|---|---|---|---|

| PyTorch Native | 15.2 ms | 65 img/sec | 개발 용이, 실서비스는 느림 |

| TorchScript | 12.8 ms | 78 img/sec | PyTorch 내 최적화 |

| ORT (CPU EP) | 9.5 ms | 105 img/sec | CPU 가속 (MKL-DNN) |

| ORT (CUDA EP) | 3.2 ms | 310 img/sec | NVIDIA GPU 활용 표준 |

onnxruntime.InferenceSession의 providers 옵션에

['CUDAExecutionProvider', 'CPUExecutionProvider']와 같이

우선순위를 지정해야 가속기를 제대로 활용할 수 있습니다.

가속기 설정에 대한 자세한 내용은 다음을 참고하세요. ONNX Runtime EP 문서 →

ONNX Runtime만으로도 충분히 빠르지만, NVIDIA GPU를 사용한다면 아직 한 단계가 더 남아있습니다. 바로 '끝판왕'이라 불리는 TensorRT 최적화 및 적용 방법입니다. ONNX가 '호환성'을 위한 것이라면, TensorRT는 '극한의 속도'를 위한 것입니다.

TensorRT는 ONNX 모델을 받아 GPU 아키텍처에 딱 맞는 형태의 엔진(binary engine

또는 .plan)으로 재조립합니다.

Conv ->

Bias -> ReLU 처럼 분리된 연산을 하나의

커널(Kernel)로 합칩니다. 이렇게 하면 GPU 메모리에 접근하는 횟수가 줄어들어

속도가 비약적으로 빨라집니다.

Calibration(보정) 데이터셋을 사용해 정보 손실을 최소화하는

과정이 필수적입니다.

trtexec 활용법

복잡한 코딩 없이 터미널 명령어 한 줄로 모델을 변환하고 성능을 측정할 수 있습니다.

# 기본 변환 및 벤치마크 (FP16 모드)

trtexec --onnx=model_optimized.onnx --saveEngine=model_fp16.plan --fp16

# INT8 변환 (보정 데이터 필요할 수 있음, 간단한 성능 측정용)

trtexec --onnx=model_optimized.onnx --saveEngine=model_int8.plan --int8 --best

이 과정을 거치면 ONNX Runtime 대비 1.5배에서 2배 이상의 추가적인 속도 향상을 기대할 수 있습니다. 2026년의 고성능 AI 서비스는 대부분 이 단계를 거쳐 배포됩니다.

TensorRT에 대한 상세 가이드는 다음을 확인하세요. NVIDIA TensorRT 개발자 가이드 → NVIDIA TensorRT Quick Start →

지금까지 PyTorch ONNX 변환 및 최적화의 전 과정을 살펴보았습니다. 2026년의 AI 엔지니어링은 단순히 모델을 만드는 것을 넘어, 이를 얼마나 효율적으로 고객에게 전달하느냐가 핵심 경쟁력입니다.

성공적인 배포를 위해 아래 항목을 반드시 점검해 보세요.

model.eval() 적용 및

dummy_input의 데이터 흐름 확인.

opset_version 선택 및 dynamic_axes 설정.

onnx-simplifier를 통한 그래프 정리.

이 파이프라인을 구축하면, 여러분의 AI 서비스는 더 적은 비용으로 더 많은

사용자에게 더 빠른 경험을 제공할 수 있습니다. 지금 바로 여러분의 모델을

export 해보세요. 속도의 차이가 곧 서비스의 차이입니다.

Q: model.eval()을 사용하지 않으면 어떤 문제가 발생하나요?

A: 학습 시에만 필요한 Dropout이나 Batch Normalization이 추론 중에도 활성화되어, 모델이 훈련되지 않은 상태처럼 잘못된 예측값을 출력할 수 있습니다.

Q: ONNX Runtime과 TensorRT 중 무엇을 선택해야 하나요?

A: 다양한 하드웨어(CPU, GPU 등)에서 호환성을 유지하려면 ONNX Runtime이 유리합니다. 반면, NVIDIA GPU 환경에서 최고의 속도가 필요하다면 TensorRT가 정답입니다.

Q: opset_version은 무조건 최신이 좋은가요?

A: 아닙니다. 배포하려는 디바이스나 추론 엔진이 해당 버전을 지원하지 않을 수 있습니다. 타겟 환경의 호환성을 먼저 확인하고 적절한 버전(예: Opset 17)을 선택하세요.

무료 SSL과 유료 SSL의 결정적 차이(신뢰도·배상금·갱신)를 2026년 기준으로 비교하고, Sectigo·DigiCert 선택 기준과 예산별 추천까지 정리했습니다.

유통업 재고관리 시스템(SaaS·WMS·ERP) 유형별 장단점과 선택 기준, 물류 연동과 AI 자동화까지 한 번에 정리한 도입 가이드.

웹사이트 필수! 보안서버 구축 완벽 가이드. SSL 인증서 종류 및 선택부터 Let's Encrypt 무료 발급, Nginx 서버 HTTPS 적용, 리디렉션 설정까지 단계별로 상세히 알려드립니다. SEO 향상과 고객 신뢰 확보를 위한 실전 노하우를 확인하세요.

2025년 중소기업 ERP 프로그램의 비용과 기능, 도입 후기를 한눈에 비교하는 가이드용 썸네일 이미지입니다.

머신러닝에서 딥러닝을 거쳐 생성형 AI와 챗GPT로 이어지는 인공지능 기술의 진화 과정을 한눈에 보여주는 인포그래픽입니다. AI 핵심 기술의 흐름을 이해하는 데 도움을 줍니다.

댓글

댓글 쓰기